重磅|清华大学教授攻克机器人最后1cm防线

时间:2016-08-16 13:07:16 来源: 机器人大讲堂

2016年7月16日,清华大学知名教授、国家杰出青年基金获得者、智能技术与系统国家重点实验室常务副主任孙富春教授做客机器人大讲堂,就“机器人视触觉认知计算”与“机械手的灵巧操作”做了精彩纷呈的报告。现将孙教授讲座内容总结整理如下:

1背景意义

比尔盖茨讲过,机器人会像PC机一样进入家庭和个人,我们已经进入了机器人的时代。过去的两年里面,机器人在人的面部特征识别,包括语音识别都取得了不少的成绩,但是机器人在灵巧操作和情感交互方面,还不及一个出生刚几个月的小孩。所以我们讲,机器人是自动化的最后一公里,而用于灵巧操作的灵巧手是机器人最后的一厘米。

如何从人的脑和手的神经运动系统的角度来研究下一代机器人。上图中人手感受到视觉叫做上行,从脑出来的一部分叫下行,叫动作预测和运动控制。即人一旦通过上行知道了在什么样的环境里这个物体是什么,并且知道了它的任务是什么,马上就能在脑的长期记忆区里面找到完成这个的经验,然后完成更多的预测和运动控制,我们想从这个角度来研究下一代的机器人。

2015年清华大学推出了类脑芯片,叫天机一号。我们现在完全可以用类脑芯片取代人脑,来完成上行的信息感知部分和下行的动作预测与控制部分。

2机器人传感技术

传感是下一代机器人操作的第一步。研究机器人各脑区是怎样合作来进行跨模态信息处理的,是当今脑科学十大问题之一。

人工皮肤方面,我们大概做了三四年了。第一代的人工皮肤是电容式的皮肤,它中间层用得是硅胶材料,灵敏度不够好。后来,我们把中间整块的硅胶变成硅帧,像帧一样,中间有两层介质,一个是轨帧,一个是空气,所以灵敏度一下子提上去了。现在我们已经做到第三代了,工艺方面做得更薄了。

触觉与图像是同构的。如何理解这句话呢?图像就是一个一个点阵,每个点阵就是像素,大小是灰度;而触觉也是一个一个点,大小是力,因此触觉和图像是同构的,这样就可以将触觉的编码方法用于视觉里面。这一原理的一个应用就是盲人识图,比如在盲人的眼睛处装两个摄像机,将图像编成触觉编码,这样盲人可以通过手来感受外部的世界。

孙教授团队在视触觉信息的编码与融合方面做了大量的研究工作,主要贡献包括视触觉的线性动态系统稀疏编码(LDS-SC)方法和三线程卷积神经网络触觉编码方法,以及基于联合稀疏编码和基于扩展贝叶斯概率推理的视触觉融合方法。

4精细操作

上面的问题告诉机器人在什么样的环境下,这个物体是什么,那么,机器人怎样操作这个物体呢?

现在大家又回到经验的办法做这个事情。抓取物体时姿态是多少,力的大小又是多少,把它记到数据库里面。

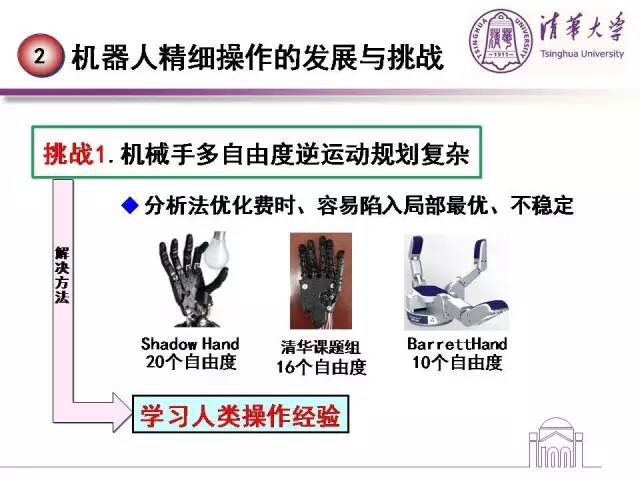

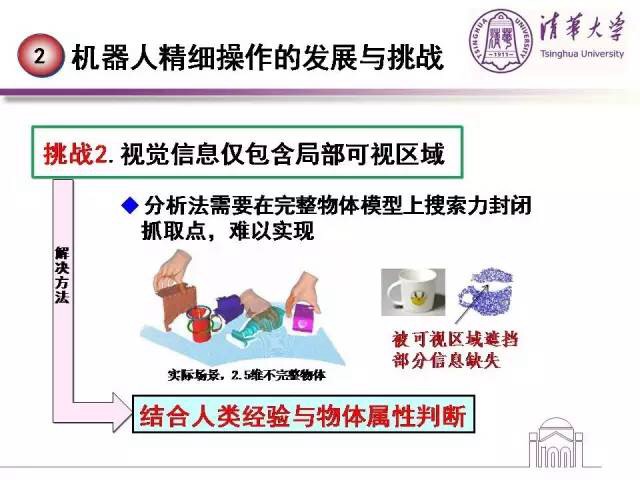

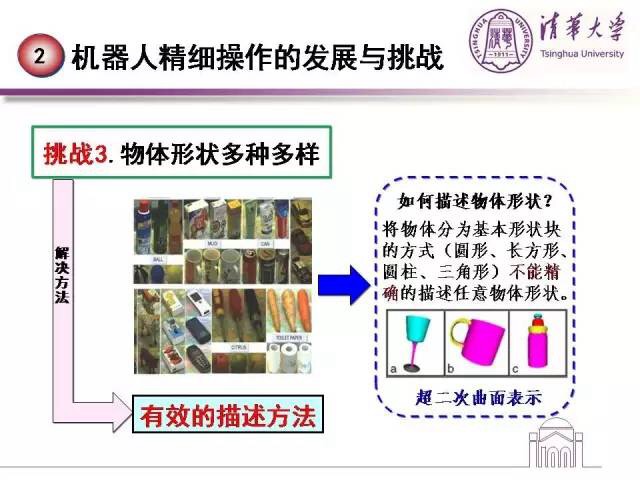

那么精细操作面临的挑战有哪些呢?

关于基于经验学习的机器人的灵巧操作,孙教授团队已有多项研究工作,在CVPR、IJCAI、ICRA、TFS、TPAMI等国际重要会议和期刊发表。

5研究展望